Zaboravljena ljudska karika. Kritika aktuelne rasprave o algoritamskoj moderaciji sadržaja iz perspektive rada

U protekloj deceniji, moderacija sadržaja na onlajn platformama često je glavna tema vesti i komentara o rasprostranjenom onlajn uznemiravanju i govoru mržnje, armijama botova koji šire dezinformacije kao sredstvo ometanja političkih izbora, ultradesničarskoj propagandi i konfuziji koja se širi lažnim vestima o kovidu-19. Novija runda ove rasprave usledila je nakon suspenzije Tviter naloga bivšeg američkog predsednika Donalda Trampa u januaru 2021. posle napada na Kapitol. Kontroverzna odluka Tvitera da najpre ograniči interakcije, zatim i da pokrije sadržaj Trampovih postove, uoči konačne suspenzije njegovog naloga, doneta je na nivou upravnog odbora kompanije. Međutim, kad je u pitanju moderacija sadržaja, ne poklanja se svakom korisniku platforme jednaka pažnja. Zbog velikog obima podataka, moderaciju vrše sistemi zasnovani na mašinskom učenju. Ljudski moderatori su zaduženi samo za reviziju odluka mašina u slučajevima kada korisnici ulože žalbu ili kada algoritmi za mašinsko učenje označe određeni slučaj kao sporan.

Zabrinut zbog mogućih posledica koje algoritamska moderacija može imati po slobodu izražavanja, Dejvid Kej, bivši specijalni izvestilac UN-a za promociju i zaštitu prava na slobodu misli i govora, zatražio je od onlajn platformi da se „[postaraju] da svaka primena automatizacije ili alata veštačke inteligencije [u ovom konkretnom slučaju, za sprovođenje pravila o govoru mržnje] ima čoveka kao kariku u lancu odlučivanja“. Mada je zabrinutost zbog implikacija algoritamske moderacije na slobodu izražavanja opravdana, zapravo se može reći da ljudi nikad nisu bili izostavljeni iz procesa moderacije sadržaja.

Termin „human-in-the-loop“ ili ljudska karika u lancu, odnosi se na potrebu za ljudskom interakcijom sa sistemima mašinskog učenja da bi se unapredio njihov učinak. Zaista, sistemi algoritamske moderacije ne mogu da funkcionišu bez ljudi koji ih opslužuju. Mašina treba da se dizajnira, napravi, održava i neprestano hrani novim podacima za učenje, što zahteva kompleksan lanac ljudskog rada.

S obzirom na sve veću ulogu moderacije sadržaja u javnom diskursu, važno je zauzeti perspektivu orijentisanu na rad da bi se razumelo kako funkcioniše algoritamska moderacija. Nasuprot popularnoj zabludi koja razlikuje mašinsku od ljudske moderacije sadržaja, praksa moderacije zapravo predstavlja mešavinu ljudi i mašina. Drugim rečima, ljudi su već prilično „u lancu“.

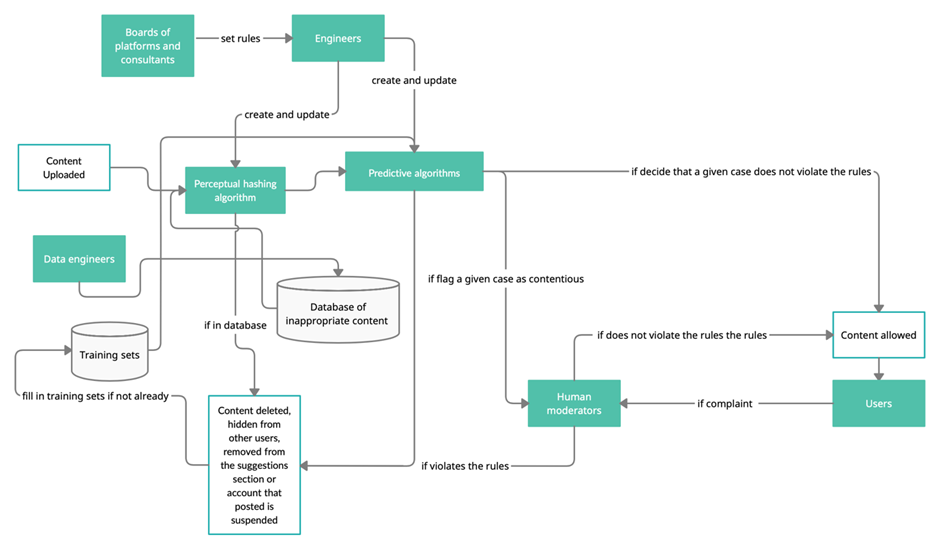

Vizuelni prikaz ukupnog učešća ljudi u procesu:

Karike ljudskog rada uključene u lanac algoritamske moderacije sadržaja

Odbori platformi

Algoritamska moderacija počinje od članova odbora platformi i zaposlenih konsultanata koji odlučuju o opštim pravilima moderacije. Ta pravila su prvenstveno proizvod potrebe za upravljanjem eksternim rizicima. Među rizicima kojima se mora upravljati su pritisci civilnog društva, regulatora i kompanija koje kontrolišu protok informacija na internetu.

Na primer, prvobitna politika Fejsbuka podrazumevala je uklanjanje fotografija dojenja. Platforma se pozivala na opštu politiku zabrane golotinje koju krši prizor otkrivenih grudi. Tek 2014, nakon višegodišnjih pritisaka aktivista pokreta Free the Nipple, Fejsbuk je dozvolio slike žena koje „aktivno doje“. Među ostalim dostignućima civilnog društva bilo je pooštravanje politike većine platformi prema govoru mržnje poput mizoginije, rasizma i eksplicitnih pretnji silovanjem i nasiljem.

Brojne, etabliranije grupe civilnog društva takođe predlažu rešenja za moderaciju na osnovu svojih etičkih principa ili ona koja su izvedena iz postojećih normi nacionalnog i međunarodnog prava. Međuvladine organizacije poput OEBS-a, Saveta Evrope i Ujedinjenih nacija imaju svoje projekte posvećene zaštiti slobode govora, uz poštovanje postojećih normi međunarodnog prava.

Pritisak regulatora najvidljiviji je u usvojenim pravilima i praksama za suzbijanje širenja terorističkog sadržaja i lažnih vesti. Ovaj drugi problem, o kome je počelo naširoko da se raspravlja nakon navodnog mešanja ruske vlade u američke izbore, privukao je dodatnu pažnju zbog biopolitičkih pitanja pokrenutih u pandemiji kovida-19.

Kada je reč o pritiscima kompanija koje upravljaju ptorokom informacija na internetu, najslikovitiji je primer društvene mreže Parler. Mreža je prestala da postoji pošto joj je Amazon obustavio cloud usluge pod izgovorom nedovoljne moderacije, dok su dve glavne distributivne platforme App Store i Google Play suspendovale aplikacije za Parler. Na sličan način, Tumblr će zabraniti golotinju, što je izazvalo masovni egzodus korisnika, nakon što je Apple izbacio aplikaciju ove platforme sa iOS App Store zbog navoda o dečijoj pornografiji. Takođe, izvršni direktor Telegrama Pavel Durov objasnio je da je odluku o gašenju kanala na kojima se objavljuju lični podaci policajaca odgovornih za brutalno rasterivanje učesnika mitinga u Rusiji, iznudila kompanija: naime, on je tvrdio da Apple nije dozvolio da apdejt za iOS aplikaciju bude dostupan dok se takvi kanali ne uklone. Tokom ruskih parlamentarnih izbora 2021, Apple i Google, pod pritiskom ruske vlade, zahtevali su da Telegram suspenduje četbota povezanog sa projektom Smart Voting koji vode saveznici osuđenog političara Alekseja Navaljnog. Četbot je ruskim glasačima pružao preporuke kandidata koje treba podržati kako predstavnici vladajuće partije ne bi osvojili mandate.

Ne pribegavaju svi izvršni direktori platformi sistemima algoritamske moderacije kao rešenju, ili bar to ne saopštavaju javno. Moderacija na mreži Clubhouse, na primer, funkcioniše bez algoritama za mašinsko učenje. Razgovore snima i čuva Agora, kompanija sa sedištem u Šangaju, koja pruža bekend usluge za ovu mrežu. U slučaju žalbe korisnika ili neke vlade, platforma analizira snimak i donosi odluku.

Odluku o tome da li da se svim ovim rizicima upravlja uz pomoć algoritamske moderacije, uvek donose članovi odbora platforme. Odbori kreiraju pravila, inženjeri pronalaze načine da ih nametnu – mada ova granica nije uvek jasna, budući da su izvršni direktori često i sami inženjeri i takođe mogu direktno učestvovati u dizajniranju arhitekture sistema.

Inženjeri

Za izbor algoritma koji će se primeniti u moderaciji sadržaja, dizajn i održavanje izabranog algoritma, zaduženi su inženjeri koji će raditi i nanjegovom unapređenju ili zameni.

Inženjeri biraju između dve glavne kategorije algoritama koje se obično koriste za moderaciju sadržaja.

Jedna grupa algoritama usmerena je na utvrđivanje delimičnih sličnosti (perceptual hashing) novih objava sa postojećom bazom neprikladnog sadržaja. Ovaj model je, recimo, efikasan u sprečavanju deljenja viralnih video snimaka masovnih pucnjava, ekstremističkih tekstova ili filmova i pesama zaštićenih autorskim pravima. Najpoznatiji primer je baza Shared Industry Hash Database (SIHD) koju koriste Google, Facebook, Microsoft, LinkedIn i Reddit. Napravljena 2017, ova baza ima sadržaje u vezi sa terorizmom, a kritikovana je zbog nedostatka transparentnosti.

Druga kategorija obuhvata algoritme koji predviđaju (machine learning) da li je sadržaj neprikladan. Tehnologije mašinskog učenja kao što su prepoznavanje govora i kompjuterski vid, efikasne su u klasifikovanju korisničkog sadržaja koji krši uslove korišćenja (ToS) platformi. Ova tehnologija je, međutim, izazvala kritike zbog diskriminacije određenih grupa, kao u slučaju prekomerne moderacije tvitova napisanih na crnačkom engleskom. Nije algoritam taj koji generiše pristrasnost, već se ona formira usled neadekvatno kompajliranih datasetova za obuku.

Vođeni naredbama upravljačkih bordova platforme, inženjeri su u stalnoj potrazi za novim skupovima podataka kako bi unapredili rad svojih algoritama. Ove datasetove ručno obeležavaju ljudski moderatori, autsorsovani saradnici na označavanju podataka i redovni korisnici.

Ljudski moderatori

Osnovna uloga ljudskih moderatora jeste da pregledaju žalbe korisnika na određene odluke koje su donele mašine i da rešavaju sporove u onim slučajevima kada je nivo sigurnosti koji prijavi algoritam nizak. Moderatori često rade za autsorsovane kompanije sa sedištem na globalnom jugu, dok su uslovi u kojima rade posebna tema za aktiviste za ljudska prava. Osim što se obično nalaze u ekonomski prekarnom položaju, moderatori trpe ogroman psihološki pritisak jer se svakodnevno bave veoma osetljivim sadržajem kao što su video prenosi samoubistava.

Posao moderatora nije ograničen na rešavanje sporova između korisnika i platforme. Ako ljudski moderatori potvrde da neka objava krši ToS platforme, taj sadržaj će, sa stručnom verifikacijom, biti priključen skupu podataka koji se koristi za algoritamsku obuku.

Uobičajena praksa pretpostavlja anonimnost moderatora. Pionirski pristup preduzeo je Fejsbuk kada je, u pokušaju da zadovolji zahtev za većom transparentnošću i unapredi legitimitet kompanije, bord kompanije uveo sistem koji u velikoj meri podseća na konstitutivnu podelu vlasti u državama. Ideja o stvaranju kvazi-legalnog pravosudnog tela u okviru Fejsbuka koje bi se bavilo pitanjima moderacije sadržaja, potekla je od Noe Feldmana, profesora prava sa Harvarda koji je učestvovao u izradi prelaznog iračkog ustava.

Platforma je 2020. uspostavila nadzorni odbor (Oversight Board, OB) koji komentatori zovu Fejsbukov Vrhovni sud. Ovaj odbor čini dvadeset članova kojima se „isplaćuju šestocifrene plate za oko petnaest radnih sati nedeljno“, a među kojima su poznati aktivisti za ljudska prava, novinari, akademici, advokati, kao i bivše sudije i političari. Do oktobra 2021, OB je usvojio 18 odluka, od kojih su neke poništile prvobitnu odluku anonimnih ljudskih moderatora ili samog odbora. Među odlukama koje je odbor podržao najznačajnija je suspenzija Trampovog naloga. Prilikom odlučivanja, OB se poziva i na smernice za zajednicu na platformi i na međunarodne standarde ljudskih prava, odnosno na odredbe Međunarodnog pakta o građanskim i političkim pravima. Budući da dvadeset članova odbora nije u stanju da pregleda sve slučajeve žalbi, njihov cilj je ograničen na reviziju najreprezentativnijih, po izaboru kompanije, kako bi dali savetodavne preporuke za politike i stvorili presedane na koje se ljudski moderatori mogu osloniti u praksi. Kompanija navodi da njihovi „timovi takođe razmatraju odluke odbora kako bi ustanovili gde se ove odluke još mogu primeniti na identičan ili sličan sadržaj“.

Kraudsorsovane oznake

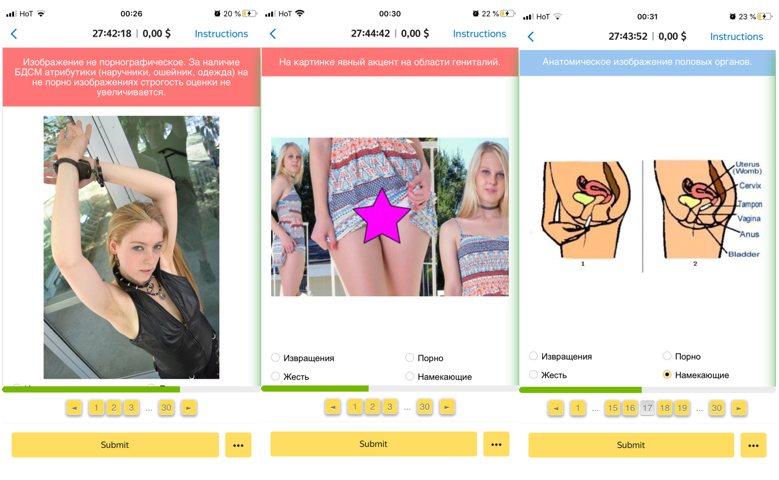

Skupove za obuku algoritama obično sastavljaju klasifikatori sadržaja koji to rade za malu finansijsku nadoknadu, preko platformi kao što su Amazonov Mechanical Turk (Mturk) ili Jandeksova Toloka. Na ovoj drugoj platformi, klasifikatori su zaduženi da raspoređuju slike u sledećih šest kategorija: „pornografija“, „nasilje“, „perverzija“, „nagoveštaj“, „ne sadrži pornografiju“, „ne prikazuje se“. Leva slika u nastavku, preuzeta iz tutorijala, označena je da „ne sadrži pornografiju“, dok su druge dve slike klasifikovane kao „nagoveštaj“. Znaci za objašnjenje govore da srednja slika prikazuje „očigledan fokus u zoni genitalija“, dok desna slika pruža anatomski prikaz genitalija. Ove poverljive skupove podataka Jandeks najverovatnije koristi za moderaciju svojih platformi društvenih medija kao što su Messenger i Zen. Ovaj drugi uživa relativnu popularnost u ruskom segmentu interneta. Istovremeno, eksplicitno normativan način na koji se ovi skupovi podataka kompajliraju, precizno ilustruje zapažanje da je „skup podataka za obuku kulturološki konstrukt, a ne samo tehnički“.

Korisnici

Redovni korisnici onlajn platformi takođe učestvuju u obuci algoritama ili ažuriranju baza podataka za algoritme koji pretražuju sličnosti, tako što prijavljuju sadržaje koje smatraju neprikladnim. Dok je za same korisnike to način da stave platformi svoje mišljenje do znanja , za platformu je prijava dragocena jer je svaka povratna informacija i neplaćeni rad na mapiranju skupova podataka za obuku prediktivnih algoritama.

Jednom kada određen broj korisnika prijavi neki sadržaj ne ispunjava uslove platforme, sadržaj se šalje ljudskim moderatorima na dalji pregled. Ako moderator potvrdi da sadržaj krši ToS, korisnici koji su ga prijavili očigledno su doprineli poboljšanju algoritama.

Zaključak

Dok su aktuelni mejnstrim pristupi analizi automatizovanih sistema moderacije fokusirani isključivo na tehničke detalje rada algoritama, ljudski učesnici u tom procesu ostaju nevidljivi. Ovaj tekst odaje počast ljudima čiji rad, izgubljen u lažnoj dihotomiji čovek-mašina, omogućava automatizovanu moderaciju, jer trenutna praksa moderacije sadržaja zapravo predstavlja isprepletanu saradnju ljudi i mašina.

Ilja Lobanov je nezavisni istraživač iz Sankt Peterburga, koji trenutno živi u Beču. Njegova interesovanja obuhvataju političku ekonomiju digitalnog kapitalizma, urbane politike i istoriju uma.

Čitaj još: